Gutachter verwenden KI für Peer Reviews

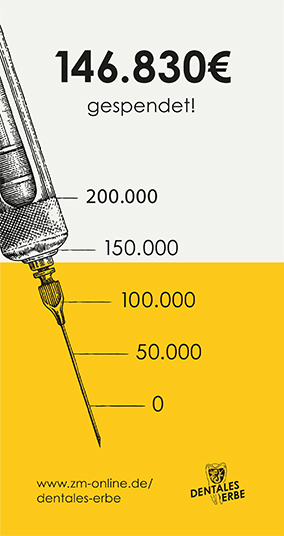

Für ihre Studie entwickelte ein Forscherteam der Stanford University, USA, eine Technik, um nach von KI geschriebenen Texten zu suchen. Dazu wurden Adjektive identifiziert, die von KI häufiger verwendet werden als von Menschen. Mit diesem Verfahren überprüften die Autoren für mehr als 146.000 Peer Reviews, ob KI-Chatbots die Peer Reviews verändert haben könnten.

Ergebnis: Die Analyse deutet darauf hin, dass bis zu 17 Prozent der Peer-Review-Berichte durch Chatbots „erheblich verändert wurden“, schreiben die Autoren. Dabei sei allerdings unklar, ob die Gutachter die KI-Tools verwendet haben, um Reviews vollständig mit KI zu erstellen oder nur, um ihre schriftlichen Entwürfe zu bearbeiten und zu verbessern. Der Vergleich der Peer Reviews vor und nach der Einführung von ChatGPT zeigt eine deutliche Zunahme jener Adjektive, die die Forschenden als die 100 von KI am häufigsten verwendeten identifizierten.

Auffällig war dabei außerdem, dass Rezensionen, die Konferenzberichte schlechter bewerteten oder kurz vor Ablauf der Frist eingereicht wurden, am ehesten diese Adjektive enthielten und „daher höchstwahrscheinlich zumindest teilweise von Chatbots verfasst“ wurden. Das galt auch für jene Bewertungen, deren Verfasser am wenigsten auf Widerlegungen durch die Autoren reagierten.

KI-Systeme halluzinieren – mal mehr, mal weniger

Die Vorstellung, dass Chatbots Gutachten für unveröffentlichte Arbeiten schreiben, sei „sehr schockierend“, da die Tools oft irreführende oder erfundene Informationen erzeugen, sagte Prof. Debora Weber-Wulff, Informatikerin an der Hochschule für Technik und Wirtschaft (HTW) Berlin, in Nature. „Die Erwartung ist, dass sich ein menschlicher Forscher damit befasst“, fügt sie hinzu und erinnerte: „KI-Systeme ,halluzinieren', und wir können nicht wissen, wann sie halluzinieren und wann nicht.“

Der Erstautor der Studie aus Stanford gibt sich weniger kritisch. „Wir wollen kein Werturteil fällen oder behaupten, dass der Einsatz von KI-Tools für die Begutachtung von Arbeiten unbedingt schlecht oder gut ist", sagt Dr. Weixin Liang. „Aber wir sind der Meinung, dass es für Transparenz und Rechenschaftspflicht wichtig ist, abzuschätzen, wie viel von dem endgültigen Text von KI generiert oder verändert worden sein könnte.“

Dass es in der wissenschaftlichen Forschung schon länger ein Problem mit Peer-Review-Prozessen gibt, weiß man in Stanford. „Es gibt einfach nicht genügend qualifizierte Gutachter, um alle Studien zu überprüfen“, schreibt die Universität, was eine besondere Herausforderung für junge Wissenschaftlerinnen und Wissenschaftler ist, denen oft der Zugang zu erfahrenen Mentorinnen und Mentoren fehlt.

Darum haben KI-Forscher aus Stanford GPT-4 und einen Datensatz von Tausenden veröffentlichter Arbeiten mitsamt den jeweiligen Gutachterkommentaren verwendet, um ein Tool zu entwickeln, das Manuskriptentwürfe vorab überprüfen kann. Die Hoffnung der Entwickler ist, dass Forschende das Tool nutzen, um ihre Entwürfe zu verbessern, bevor sie offiziell bei Konferenzen und Zeitschriften eingereicht und – von menschlichen Experten – bewertet werden.

Weixin Liang et al., Monitoring AI-Modified Content at Scale: A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews, arXiv:2403.07183 [cs.CL] (or arXiv:2403.07183v1 [cs.CL] for this version) https://doi.org/10.48550/arXiv.2403.07183